如果人形机器人接入ai大模型会发生什么?

本文摘要

将人形机器人与AI大模型(如GPT-4、多模态大模型等)结合,可能会引发技术、社会和伦理层面的深远变革。以下是可能发生的关键影响:1. 技术层面的突破自然交互能力跃升:机器人能通过自然语言、表情、动作与人类无缝...

****更多行业产品开发方案,请关注 加速度JSUDO***

<以上资讯仅供参考,如果您需解决具体问题,建议您关注作者;如果有软件产品开发需求,可在线咨询加速度产品经理获取方案和报价>

加速度是一家专注于为企/事业单位的供应链提供数字化营销/服务的公司,产品线涵盖线上营销策划、商城开发、智慧园区、智能客服和企微SCRM系统,应用于营销推广-线上交易-销售管理-物流配送和服务支持等,致力于帮助企业开发更具投资价值的“数字”资产产品。

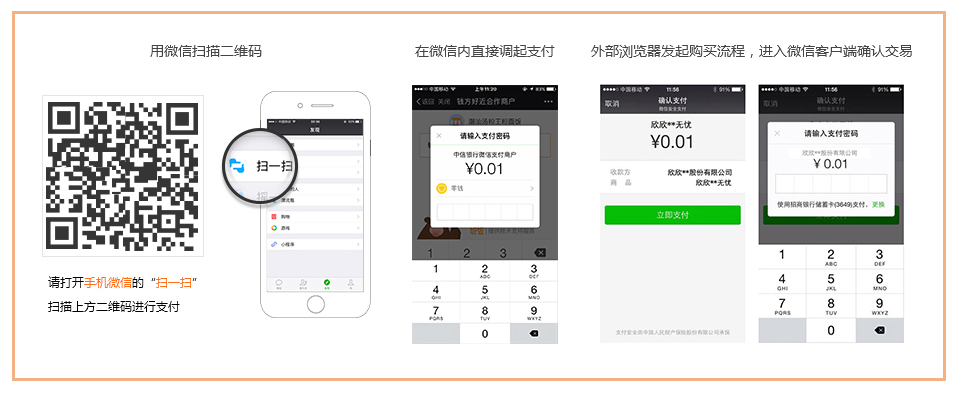

添加客服微信获取更多内容